Helm po raz drugi – czyli wersjonowanie i rollbacki dla Twojej aplikacji

Opisujemy jak wykonać aktualizację i rollback w Helm, jak elastycznie nadpisywać wartości oraz odkryjemy, czym są i jak działają szablony.

Autor:

Autor:W tym artykule dowiecie się o technologiach Infiniband oraz RDMA, które pozwoliły podnieść przepustowości w systemach interconnect w klastrach obliczeniowych, a także obniżyły opóźnienia. Skutkuje to zwiększoną wydajnością superkomputerów i innych systemów i eliminuje wąskie gardła. Zainteresowani? Zapraszamy do lektury!

Infiniband – czym jest?

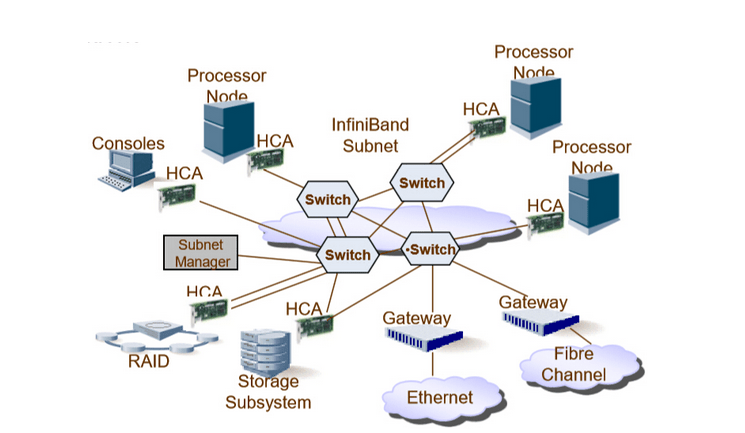

InfiniBand to szybka technologia sieciowa używana do łączenia serwerów, urządzeń pamięci masowej i innych zasobów sieciowych w centrach danych i środowiskach obliczeń o wysokiej wydajności (HPC). Została zaprojektowana, aby zapewnić łączność o niskim opóźnieniu i dużej przepustowości. Jest stosowana w systemach HPC oraz superkomputerach. Z Infiniband wiążą się inny stos protokolarny, nie jest to jak w przypadku klasycznych sieci TCP/IP. W Infiniband występują takie pojęcia jak:

Rysunek 1: Przykładowa architektura sieci Infiniband wraz z węzłami przetwarzającymi dane i pamięcią masową. Źródło: jcf94.com.

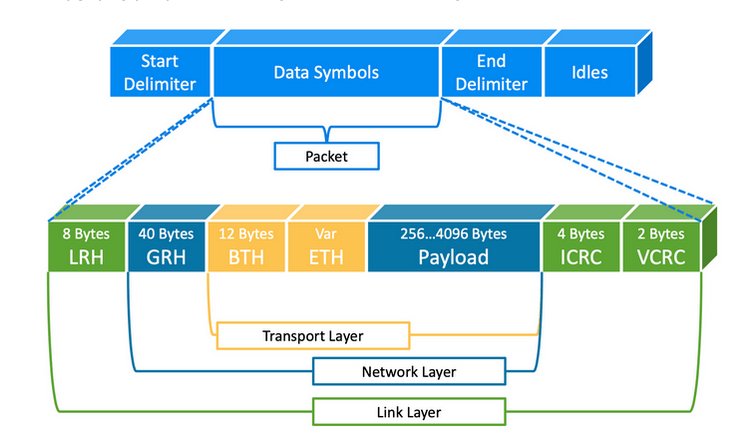

Należy także zwrócić uwagę na to, że ponieważ stosujemy zupełnie inne protokoły, to ramki również wyglądają zupełnie inaczej niż w standardowej sieci Ethernet.

Rysunek 2: mamy zupełnie inne nagłówki niż w Ethernecie, które powiązane są z identyfikatorami wyróżnionymi w sieci Infiniband Źródło: ACM-Study-Group.

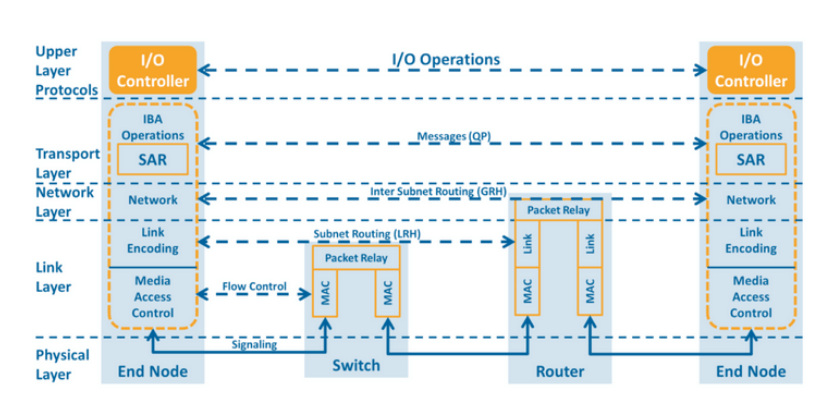

Stos protokołów sieciowych można zobrazować w następujący sposób w ramach 4-warstwowego modelu sieci:

Rysunek 3: model sieci Infiniband Źródło: ACM-Study-Group.

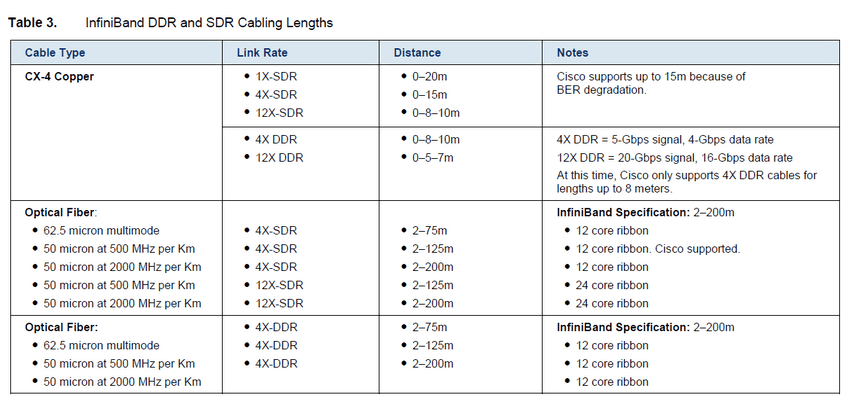

Okablowanie Infiniband

Standardy okablowania dla Infiniband są definiowane zarówno dla przewodów miedzianych jak i światłowodów. To co jest najbardziej interesujące, to jak restrykcyjne są normy w przypadku budowy takiej infrastruktury. Dla przewodu światłowodowego maksymalny dystans wynosi 200 m. Dlaczego? Dłuższy światłowód powoduje opóźnienia i staje się wąskim gardłem dla całego systemu.

Rysunek 4: Standardy okablowania dla Infiniband.

Dodatkowo warto wspomnieć, że wiele innych standardów blisko współpracuje z Infiniband i jest w stanie korzystać z takiej sieci w ten czy inny sposób. Na przykład:

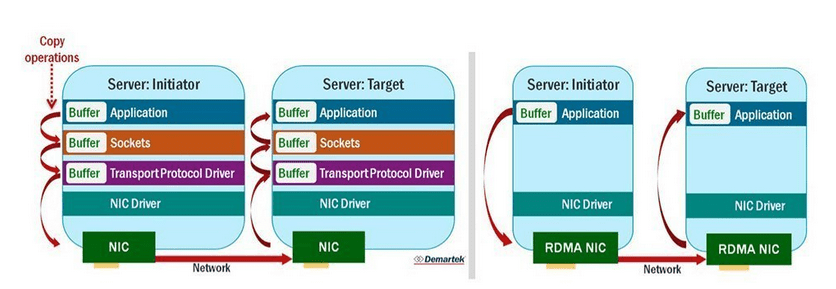

DMA vs RDMA

Jednym z najistotniejszych elementów sieci dla superkomputerów i innych systemów o wielkich prędkościach jest eliminowanie wąskich gardeł wynikających z ograniczeń technologicznych. Jednym z takich elementów był problem z angażowaniem procesora w komunikacji sieciowej oraz problem stosu sieciowego. Dzięki RDMA jesteśmy w stanie uzyskać naprawdę niskie opóźnienia na poziomie mikrosekundy.

DMA (ang. Direct Memory Access) – to technologia umożliwiająca przesyłanie danych między urządzeniem a pamięcią bez interwencji procesora. DMA służy do poprawy wydajności systemu poprzez odciążenie procesora i umożliwienie mu wykonywania innych zadań w trakcie przesyłania danych.

Remote Direct Memory Access (RDMA) to dostęp do pamięci jednego komputera do drugiego w sieci bez angażowania systemu operacyjnego, procesora i pamięci podręcznej. Poprawia przepustowość i wydajność systemów. Operacje takie jak odczyt i zapis mogą być wykonywane na zdalnej maszynie bez przerywania pracy procesora tej maszyny. Ta technologia pomaga w szybszym przesyłaniu danych w sieciach, gdzie kluczowe są niskie opóźnienia.

Integralną częścią RDMA jest koncepcja zero-copy networking, która umożliwia odczytywanie danych bezpośrednio z pamięci głównej jednego komputera i zapisywanie tych danych bezpośrednio w pamięci głównej innego komputera. Transfery danych RDMA omijają stos sieciowy kernela na obu komputerach, poprawiając wydajność sieci. W rezultacie konwersacja między dwoma systemami zakończy się znacznie szybciej niż porównywalne systemy sieciowe inne niż RDMA.

Rysunek 5: Porównanie klasycznych adapterów sieciowych z tymi z funkcją RDMA.

Według badań (WangJangChenYiCui’17) najsłabsza implementacja RDMA w ma 10-krotnie mniejsze opóźnienie niż najlepsza bez RDMA. Dla Infiniband jest to 1.7 mikrosekundy opóźnienia. Dlatego, jak już wcześniej pisaliśmy, przewody światłowodowe mają za zadanie mieć do 200m, ponieważ eliminuje to potencjalne powstanie wąskiego gardła na samym światłowodzie (opóźnienie światłowodu ok. 5 mikrosekund na kilometr).

Kalkulator opóźnienia w światłowodzie: https://www.timbercon.com/resources/calculators/time-delay-of-light-in-fiber-calculator/

Ethernet kontra HPC

Ethernet to powszechnie stosowana technologia sieciowa, która jest również wykorzystywana w niektórych środowiskach wysoce wydajnych obliczeń (HPC). W przeszłości Ethernet nie był uważany za odpowiednią technologię łączenia dla HPC ze względu na wysokie opóźnienia i niższą przepustowość w porównaniu do innych łączy HPC, takich jak InfiniBand. Jednakże, dzięki rozwojowi nowych standardów i technologii Ethernet, takich jak RDMA over Converged Ethernet (RoCE), Ethernet staje się wariantem opłacalnym dla niektórych obciążeń roboczych HPC. RoCE umożliwia transfer danych między serwerami, a urządzeniami pamięci masowej z niskim opóźnieniem i wysoką przepustowością, co czyni go obiecującą opcją dla klastrów HPC, które wymagają łączy o dużej prędkości.

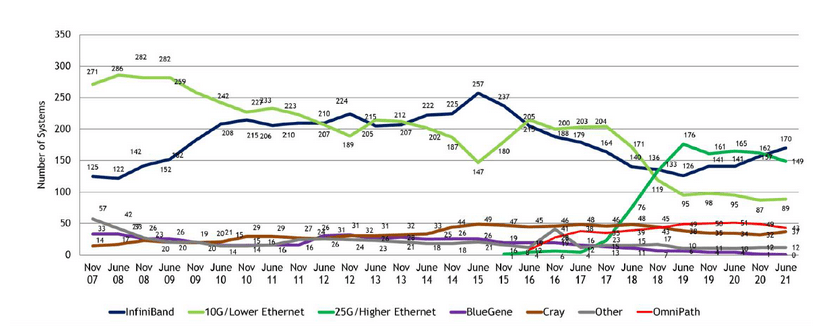

Podsumowanie

Istnieje wiele technologii, które przyczyniają się do sukcesywnego zwiększania przepustowości oraz zmniejszania opóźnienia czy kosztów. Naukowcy starają się prowadzić badania na wielu frontach, a biznes szuka kosztowo optymalnego rozwiązania dla superkomputerów. Warto w tym miejscu przytoczyć statystyki, które pokazują jakie technologie są najczęściej wykorzystywane w systemach wysokowydajnych.

Rysunek 6: Trendy technologiczne dla 500 najlepszych superkomputerów, źródło: Nvidia.

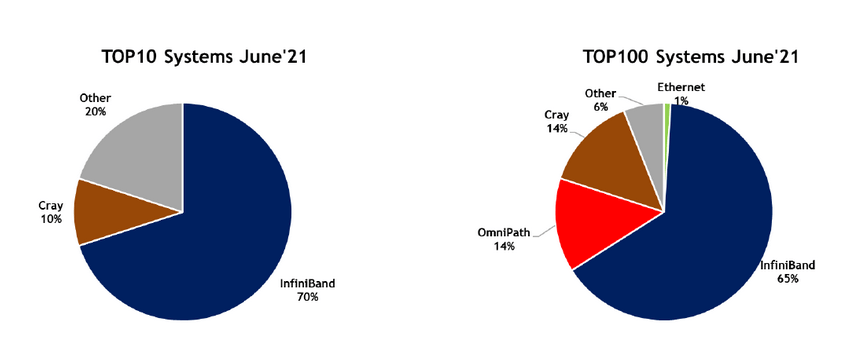

W ostatnich kilku latach widać znaczącą dominację dwóch technologii, które opisaliśmy w tym artykule – Infiniband oraz Ethernet.

Rysunek 7: Procentowy udział poszczególnych technologii interconnect w top10 oraz top 100 systemów, źródło Nvidia.

Pomimo widocznego wzrostu znaczenia Ethernetu w ostatnich latach w systemach HPC nie ma on praktycznie żadnego znaczenia w pierwszej setce rankingu, gdzie dominuje Infiniband. Zachęcamy do zapoznania się z listą, gdzie konkretne superkomputery mają przedstawione swoje parametry i systemy interconnect. https://www.top500.org/lists/top500/list/2022/11/

Mamy nadzieję, że ten artykuł dał Wam pigułkę merytorycznej wiedzy w temacie superkomputerów i połączeń używanych w tych systemach. Jest to szeroki temat, w który ze względu na szeroką gamę zastosowań inwestują wielkie firmy.

Źródła:

Helm po raz drugi – czyli wersjonowanie i rollbacki dla Twojej aplikacji

Opisujemy jak wykonać aktualizację i rollback w Helm, jak elastycznie nadpisywać wartości oraz odkryjemy, czym są i jak działają szablony.

AdministracjaInnowacja

Helm – czyli jak uprościć zarządzanie w Kubernetes?

Warto o tym wiedzieć! Czym jest Helm, jak go używać i jak ułatwia on korzystanie z klastra Kubernetes?

AdministracjaInnowacja

INNOKREA na Greentech Festival 2025® – zdobyliśmy zielone serce Berlina!

Jak wygląda przyszłość zielonych technologii i jak nasza platforma wpisuje się w ideę recommerce? Relacjonujemy nasz udział w Greentech Festival w Berlinie – zobaczcie, co przywieźliśmy z tego inspirującego wydarzenia!

WydarzeniaZielone IT